|

Seiten: | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 |   Die GeForce 8800 GTX

Architektur

Speicherdurchsatz zählt

ROP and

Speicheranbindung

Die GeForce 8800 besitzt

6 Raster Operation Einheiten (ROP), von denen jede 4 Pixel

(16 subpixel samples) pro Takt abarbeiten kann. Die ROPs

unterstützen multisampled, supersampled, und transparency

adaptive antialiasing. Dabei sind auch die neuen Modi 8x,

8xQ, 16x und 16xQ, die wir später noch ansprechen. Die ROPs unterstützen

ebenso frame buffer blending in FP16 und FP32, womit auch in

Zusammenhang mit HDR multisampled Antialiasing möglich ist.

Und zwar in allen und nicht wie bisher in einige

ausgewählten Anwendungen.

Der Speicher der GeForce

8800 GTX GPU ist, wie im Block Diagramm zu sehen, in 6

Partitionen (5 bei der GTS) geteilt. Jede dieser Partitionen hat eine 64-Bit

Anbindung zum Speicher der Grafikkarte, womit man auf ein

384-Bit Speicherinterface (320-Bit bei GTS) kommt.

Die GeForce 8800 GPU kann mit DDR1, DDR2, DDR3, GDDR3 und auch GDDR4

Speicher arbeiten. Die GeForce 8800 GTX Karte benutzt

derzeit GDDR3

Speicher, der mit 900 MHz getaktet ist. Zusammen mit dem

384-Bit Interface kommt man so auf eine Bandbreite von 86.4

GB pro Sekunde. Die GeForce 8800 GTX ist mit 768 und die

GeForce 800 GTS mit 640 MB Speicher ausgestattet, wobei hier

auch andere Kombinationen denkbar sind.

Weiter Optimierungen

Natürlich wurde auch

sonst an der GeForce GPU weiter optimiert.

-

Decoupled Shader

Math and Texture Operations

Bei der GeForce 7 GPU waren die Berechnung von

Texturen Adressen mit den mathematischen Shader

Operationen in Einheit 1 einer Pixelpipeline gekoppelt.

In ungünstigen Situationen konnte es hier also zu einem

"Flaschenhals" in der Berechnung kommen. Bei der GeForce

8800 läuft dies unabhängig voneinander ab und verbessert

so die Shader Performance.

-

Branching

Efficiency Improvements

Die GeForce 7 GPU ist auf DirectX 9 Shader

optimiert. Beim Treffen auf eine Abzweigung (IF-THEN-ELSE)

im Shader Code wurde bei der GeForce 7 eine Gruppe von

880 Pixeln auf einmal bearbeitet. Bei der GeForce 8

wurde diese Granularität für komplexe DirectX 10 Shader

deutlich reduziert. Die GeForce 8800 GPU bietet nun ein

16 Pixel branching oder 32 Pixel branching an. Bei der

ATI X1900 sind es 48 Pixel.

-

Early Z Comparison

Checking

Eine wesentliches Element in einer 3D Szene ist

welches Objekt von einem anderen Objekt verdeckt wird

und somit für den Betrachter sichtbar oder eben nicht

sichtbar ist. Dazu dient der so genannte Z-Buffer, der

genau diese Informationen speichert. Die GeForce 8800

GPU arbeitet hierbei mit einem Early-Z Verfahren, das

Sichtbarkeit eines Pixels ermittelt bevor es durch

diverse Weiterverarbeitungsprozesse wandert. Somit wird

Rechenleistung gespart, was die GPU schneller macht.

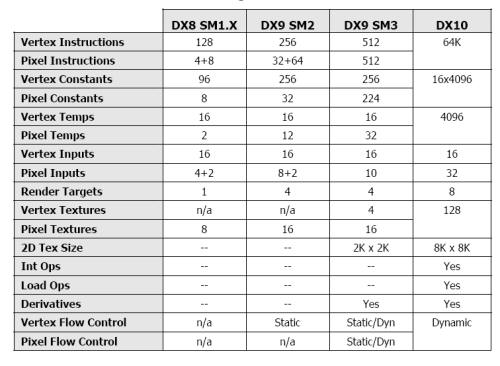

DirectX10 Design (Shader

Model4, Stream Output, Geometry shaders etc.)

Die GeForce 8800 Serie

enthält alle von DirectX10 spezifizierten Hardware

Funktionalitäten und bietet komplette Unterstützung der

DirectX 10 unified shader instructions. Mit DirectX 10 wird das

Shader Modell 4 Einzug halten, das eine Erweiterung des

Schadermodels 3 darstellt. Es ist flexibler und ermöglicht

mehr Effekte als die bisherigen Shader Modelle, was sich

leicht anhand einer Tabelle ablesen lässt.

Limitierungen der verschiedenen Shader Modelle.

Dt

der "Stream Output" eines der wesentlichen Features von

DirectX 10 und somit auch der GeForce 8800. Vereinfacht gesagt können damit Objekte aus der

3D Welt zwischengespeichert und später auch mehrfach

weiterverarbeitet werden. Im Zusammenhang mit dem

Stream Output tritt auch der Begriff des "Improved

Instancing" auf. Dies bedeutet nichts weiter, als das es nun

in DirectX 10 einfacher und schneller möglich ist aus einem

einzelnen Objekt eine Vielzahl ähnlicher Objekte zu

erzeugen. So lässt sich zum Beispiel aus einem einfachen 3D

Objekt eines Baums ein Wald erstellen, oder aus

einer einzelnen 3D Figur eine Menge von unterschiedlichen

Figuren, die aber alle eine gleiche Basis haben. Wichtig

dabei ist das die Objekte nicht einfach kopiert werden,

sondern eben beliebig wieder die Bearbeitungsphasen in der

3D Berechnung durchlaufen können.

Eine der größten

Herausforderungen in diesem Bereich, den die GeForce 8800

auch meistern soll, ist das Darstellen realistischer Haare,

denn prinzipiell treffen hier alle genannten Punkte

zusammen. Eine große Masse des gleichen Objekts, in doch

unterschiedlicher Länge oder Form, sich bewegend und

entsprechend beleuchtet, darzustellen war bisher kaum

möglich und benötigt fast jede der

oben genannten Techniken und greift dazu auch noch auf

Physik Berechnungen zurück. All diese Berechnungen können

bei der GeForce 8800 in der GPU durchgeführt werden, während

sich dies bei der GeForce 7 Serie noch überwiegend, bis auf

die eigentliche Darstellung der Haare, in der CPU abspielte.

Ebenfalls neu sind die so

genannten Geometry Shader. War es bisher so dass im Vertex

shader einzelne Ecken eines 3DModels verändert wurden, so

kann der Geometry Shader nun ganze Objekte verarbeiten.

Bisher war dies zwar auch schon möglich, aber eben nur in

der CPU und nicht direkt in der GPU. So wird es zum Beispiel

möglich Objekte zu animieren, ohne dabei die CPU zu belasten.

Als Beispiel kann hier auch das Explodieren eines Objekts

genannt werden, also das Zerlegen es 3D Objekts in einzelne

kleinere Objekte.

Neue SLI Technology

Einer der Punkte, die bei

der GeForce 8800 noch nicht ganz klar sind, ist das neue SLI

Interface. Im Gegensatz zu den alten NVIDIA Karten besitzen

die 8800 GeForce Karten nun zwei SLI Anschlüsse. Diese

werden aber offenbar noch nicht genutzt, denn den SLI Modus

aktiviert bei der GeForce 8800 auch schon eine einzelne Brücke.

Das

zuschalten einer zweiten Brücke bringt keine Veränderungen

mit sich, wie wir ausprobiert haben. Anders gesagt, das neue SLI Interface wird offenbar vom aktuellen Treiber noch nicht

unterstützt, ist wirkungslos, oder aber für ganz andere

Dinge gedacht als nur 2 Karten zusammen zu schalten. Dazu

haben wir bereits Gedanken in einer

News veröffentlicht.

Quantum Effects

GPU-Based Physics

Quantum Effects klingt in

jedem Fall schon mal nicht schlecht und ist nun auch

eingetragenes Warenzeichen von NVIDIA. Was Quantum Effekts

genau ist, dazu gibt es leider noch keine wirklichen

detaillierten Infos, aber prinzipiell handelt es sich

hierbei um einen Physikbeschleuniger in der GPU. Wie wir

bereits gesagt haben, kann ein Stream Prozessor der GeForce

8800 auch Physik Berechnungen durchführen und mit immerhin

128 Stück davon kommt einiges an Rechenleistung zusammen.

Laut Nvidia soll damit Haarbewegung, Wasser, Rauch, Feuer

und was sonst aktuell in Games noch eher unrealistisch

dargestellt wird deutlich schöner werden. Allerdings erst

mit DirektX10, denn aktuell ist von Softwareunterstützung

noch nichts zu sehen.

PureVideo und

Purevideo HD

Auch in Sachen Video soll

die GeForce 8800 noch bessere

Bildqualität liefern. PureVieo soll die Bildqualität von

H.264, VC-1, WMV/WMV-HD, and MPEG-2 HD verbessern. Als

Outputformate stehen 720p, 1080i, and 1080p mit 3:2 and 2:2

Pulldown zur Verfügung. Dazu gibt es HD Noise Reduction und

HD Edge Enhancement. Zudem erlaub die GeForce

8800 die Wiedergabe von AACS geschützten Blue-ray und HD DVD

Filmen mit entsprechender Player Software. Alle GeForce 8800

Karten sind zudem HDCP kompatibel.

Nach angaben von NVIDIA

erreicht die GeForce 8800 GPU im HQV DVD Benchmark ganze 128

von 130 möglichen Punkten, was die Leistungsfähigkeit der

neuen GPU in Sachen Videowiedergabe deutlich macht.

Extreme HD Gaming (XHD)

Bereits mit der GeForce

7900 GTX und Quad SLI ist bei NVIDIA der Begriff des XHD

Gamings eingeführt worden. Dabei geht es um Spiele, die auf

einem 30'' Display in der Auflösung von 2560x1600 gespielt

werden. Mit der GeForce 8800 ist dies nun wirklich mit

exzellenten Frameraten möglich und bei einer SLI Kombination

von 8800 Karten sogar mit hohem Antialiasing.

CUDA - Compute Unified

Device Architecture (Built for Microsoft Windows Vista)

Mit Windows Vista soll

noch ein weiteres Feature die Freude an der GeForce 8800

erhöhen, welches mit Gaming relativ wenig zu tun hat, aber "Rechenfreaks" begeistern dürfte. Mittlerweile haben 3D

Karten eine enorme Rechenleistung und solange man auf dem

Desktop einen Text in Word tippt liegt diese reichlich

brach.

Das man die GPU, wenn man

nicht gerade anspruchsvolle 3D Darstellungen auf den

Bildschirm zaubert, auch anderweitig nutzen kann, war wohl der

Hintergedanke bei CUDA - Compute Unified Device

Architecture. Dabei handelt es sich um eine Hard und

Softwarelösung, um datenintensive Berechnungen durchzuführen.

Als Features werden aufgelistet

-

Neues "Thread

Computing" Verarbeitungsmodel, das die Architektur der

GeForce 8800 GPU benutzt

-

Threads können auf

der GPU "kooperieren" und "kommunizieren"

-

Standard C

Programmierinterface bietet eine einfach Plattform für

komplexe Rechenprobleme

-

Architektur ergänzt

die Standard CPU um zusätzliche Leistung für

Applicationen, die an sich parallel zu verarbeiten sind.

-

Die CDUA technology

verwendet die GPU für andere Aufgaben als die

Grafikberechnung. Dennoch können beide Aufgaben auch

gleichzeitig durchgeführt werden, wenn dies erforderlich

bzw. gewünscht ist.

Was kann man nun

überhaupt damit anfangen? Nun es handelt sich hier derzeit

wohl eher um Anwendungen im wissenschaftlichen Bereich, die

von der Lösung profitieren können. Welche Rechenpower da auf

einen zukommt, kann man sich in etwa vorstellen, wenn man

bedenkt, dass eine NVIDIA 8800 GTX GPU insgesamt 128 1,35 GHz

Floating Point Prozessoren besitzt. Und der Einsatz ist auch

unter SLI möglich. Dann stehen einem also 256 "kleine" 1,35

GHz Prozessoren zur Verfügung, die weitgehend parallel

arbeiten.

NVIDIA bietet für das

CUDA eine komplette Entwicklungsumgebung mit standard C

Compiler, mathematischen Libraries und Treibern für

Windows (Vista?) und auch Linux an. |

KING DEALS! Jetzt bis zu 60% auf Top-Hardware von Markenherstellern sparen!

KING DEALS! Jetzt bis zu 60% auf Top-Hardware von Markenherstellern sparen!  KING DEALS! Jetzt bis zu 60% auf Top-Hardware von Markenherstellern sparen!

KING DEALS! Jetzt bis zu 60% auf Top-Hardware von Markenherstellern sparen!